La presentación del observatorio de la desinformación y la violencia simbólica en medios y plataformas digitales reavivó el debate- ya fogueado por el decreto que vuelve servicio público a los servicios de Tv por cable e internet- acerca del rol del Estado en la regulación de los legitimados para difundir la información en nuestro país.

Pensarnos inmersos en sociedades de la información que llevan más de 50 años en funcionamiento es un buen primer paso para comprender el fin de este artículo. Si la información es el producto que aporta y genera valor en una sociedad dada, la comprensión de su contenido, su utilización y el fin de su circulación para ejercer una sana ciudadanía y sostener el sistema democrático nos exige -al menos- vigilancia y cautela.

Las operaciones, decisiones y elecciones que otrora se otorgaban exclusivamente a acciones humanas están siendo delegadas crecientemente a los algoritmos, tanto en el periodismo tradicional como en la circulación informativa en plataformas (preferiría llamarlos a ambos sistemas híbridos mediáticos). Estos sistemas complejos pero amigables son muchas veces los responsables de recomendar contenidos, o más aún, decidir cómo deben interpretarse los datos recolectados y qué acciones deben ser tomadas en cada feed de nuestras aplicaciones más usadas. Léase aquí desde una love app como Happn o Tinder, pasando por las clásicas Facebook Whatsapp e Instagram (todas del mismo dueño el Sr. Zuckerberg), hasta otras más novedosas como Tik Tok, llegando hasta un sitio web de corte tradicional como podría ser un medio de comunicación digital.

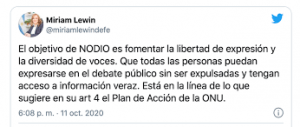

Resulta innegable que este último tiempo, el debate en torno a los discursos de odio y los algoritmos han resonado casi como una agenda impuesta desde los organismos estatales, supranacionales y mediáticos. La misma semana en que Facebook prohíbe y cierra definitivamente grupos negacionistas del holocausto nazi, la defensoría del público presenta en Argentina NODIO, un observatorio cuya línea de investigación se inscribe en la búsqueda de la forma en que circulan discursos que portan violencia simbólica y desinformación.

Recordemos que la Defensoría del Público es un organismo creado por el artículo 19 de la ley de Servicios de Comunicación Audiovisual (Ley 26.522) bajo la órbita del Congreso Nacional para defender la libertad de expresión de todas las personas que habitan la Argentina. Tiene entre sus misiones y funciones recibir y canalizar los reclamos y consultas de las audiencias y no tiene capacidad sancionatoria alguna. Aquí es importante remarcar que tampoco la tendría el observatorio de la desinformación y la violencia simbólica en medios y plataformas digitales (como si medios y plataformas fuesen cosas distintas).

En un comunicado publicado recientemente, la Defensoría sostiene que “El Observatorio aportará una mirada desde el estudio cualitativo y cuantitativo de la violencia simbólica y las noticias maliciosas ya emitidas. No existen intenciones de llevar adelante ni el control, ni la supervisión de la tarea de la prensa: son actividades incompatibles con las funciones del organismo”. Tal ha sido el revuelo que provocó en el mundo mediático tradicional —y en el mundo del Poder Judicial también— en torno a la defensa de la libertad de expresión, que nos perdimos en un mar de acusaciones y temores infundados que poco construyen en términos de ciudadanía y debate público de problemáticas reales que nos aquejan como sociedad.

Esas que nos afectan a diario, como son las fake news, los discursos polarizantes y la desinformación como actos performativos, es decir, pensados y diseñados para favorecer a un alguien y dañar a un otro. Muchas de ellas vehiculizadas y viralizadas por los famosos —pero opacos— algoritmos.

Para realizar una reflexión respecto de qué significa la posible sustitución de cogniciones enunciada en el título de este artículo, primero hay que aclarar una cuestión relevante. Sustituir algo es reemplazarlo. A veces se sustituyen importaciones, y eso es bueno para un país y su economía. Ahora bien, cuando la técnica se encarga de sustituir algo propiamente humano estamos en un problema grave. La cognición es condición constitutiva del ser. Las máquinas no pueden ser, a no ser que las dejemos. Y la idea es, de a poco, aprender cómo no dejarlas.

Por ello es importante conocer qué son y para qué sirven los algoritmos. “Algoritmo” cuenta con una colección de significados a lo largo de la ciencia computacional, la matemática y el discurso público. Como explica Hill (2015), “Vemos evidencia que cualquier procedimiento o proceso de decisión, aunque mal definida, puede ser llamado un algoritmo en la prensa y el discurso público. Oímos, en las noticias, de algoritmos que sugieren potenciales compañeros para personas solteras y algoritmos que detectan tendencias de beneficios financieros a comerciantes, con la implicancia de que esos algoritmos puedan estar en lo correcto o no…”. Se debaten categorías técnicas y matemáticas u otras más normativas y formales en torno a este popular término que se ha instalado en nuestros debates. Resulta ineludible incorporar el algoritmo en una discusión sobre la forma en que nos informamos y tomamos decisiones.

De manera general, se puede decir que el término se usa no en referencia al algoritmo como constructo matemático, sino más como la implementación e interacción de uno o más algoritmos en un programa en particular, software o sistema de información. Es decir, como un generador de coincidencias o correlaciones impensadas e imposibles para la mente humana. Su utilización se debe, no solo a su capacidad de procesar miles de millones de datos en tiempos muy acotados, sino también por su habilidad de interpretar esos datos automatizadamente, superando nuestras facultades de asociar factores. Una “administración robotizada”, racionalizada e intuitiva que regula de alguna forma lo social como sostiene Sadin (2017).

La exposición a agregadores de noticias, a las informaciones de dudosa fuente vía Whatsapp, así como la elección y sugerencias de las cuentas a las que seguimos en una red social, sumado a esta capacidad algorítmica de mostrarnos aquello que cognitivamente se nos asemeja, habilitan esta reflexión como puntapié del debate: las tecnologías programadas, la técnica aplicada a la cognición humana reemplaza la necesidad del ser humano de tomar decisiones y de evaluar su entorno. No en su totalidad, pues no quiero ser en esto determinista. Pero avanza a pasos de gigante.

Se trata de un individuo asistido con paracaídas, como dice Žižek (2015), no dispuesto a correr riesgos, exponiéndose sólo a lo seguro, pero sintiendo la adrenalina. Evitando la disonancia cognitiva, aquello que no coincide con lo que uno cree y, por ende, reforzando el sesgo de confirmación que nos deja en puerto seguro siempre.

Cuando tres investigadores norteamericanos Kraft, Lodge y Taber (2015) analizaron por qué no confiamos en la evidencia probatoria actuando con híper escepticismo, hallaron que en el razonamiento motivado políticamente se halla la respuesta. Sin importar su ideología, ante una evidencia que contradice lo que pensamos, elegimos no creer. Tendemos a buscar información que sea consistente con nuestras creencias previas e interactuamos con contenido que es consistente con nuestras creencias previas. De allí que las informaciones falsas se vuelvan “obviamente correctas” si coinciden con nuestro pensamiento, evitándonos el paso del chequeo, o la acción cognitiva. Esta última, entendida como la capacidad del ser humano para conocer por medio de la percepción y los órganos del cerebro el ambiente en el que habitamos social, económica y políticamente.

A juicio de quien escribe, en estos tiempos resulta necesaria la observancia, el extrañamiento, el tomar distancia de estos fenómenos que, si bien no son “nuevos”, sí resultan potencialmente un impacto social “novedoso”. Debemos describir estos procesos en términos de meras especulaciones teóricas, plasmar en tinta lo que ocurre, registrarlo para poder luego concluir o desarrollar un plan de acción. No dejar que nos sustituyan la cognición. No permitir que nos reemplacen con algoritmos aquello que nos viene naturalmente otorgado en la mente. Ejercer la résistance, pero de modos simples. Tomar decisiones conscientes, preguntarnos más qué leemos, evitar el consumo incidental de información, entrenarnos en la exposición a la misma —si se quiere— para un enemigo bastante poderoso, pero prácticamente invisible. Cada vez que se enfrente a una información, frene. Pregúntese. ¿Quiero leer esto, busqué yo por decisión propia esta información, necesito saber acerca de esto, debería chequear lo que observo al menos con un par?

Con objetivos económicos y publicitarios, mediante plataformas o interfaces, campañas electorales, grupos de presión o grandes conglomerados de inversión difunden información que impacta en nuestra forma de concebir el entorno que habitamos, el modo en que actuamos, los productos que consumimos y, eventualmente, los líderes que elegimos. Es un problema cíclico. Esto es lo que debe importar, poner ahí el ojo en el seguimiento y la regulación futura. Si la sustitución de cogniciones (que en nada se asemeja a la sustitución de importaciones, que sería poner en marcha la técnica en favor de la sociedad) no es vista como una alerta de pérdida de humanidad en el marco de un problema tan complejo como el de la circulación de los discursos de odio y la violencia simbólica en medios y plataformas, no estamos viendo la imagen completa. Para finalizar, y dejar a los lectores poniendo en marcha sus cogniciones, rescato la frase de James Scott (2020) “Con el paso del tiempo, los bosques se parecen cada vez más a los libros que los describen”. No dejemos que las sociedades a las que pertenecemos se parezcan cada vez más a las narraciones y comentarios de los medios híbridos con los que gestionamos nuestra cognición.

Referencias Bibliográficas:

Hill, R. K. (2016). What an algorithm is. Philosophy & Technology, 29(1), 35-59.

Kraft, P. W., Lodge, M., & Taber, C. S. (2015). Why people “don’t trust the evidence” motivated reasoning and scientific beliefs. The ANNALS of the American Academy of Political and Social Science, 658(1), 121-133.

Sadin, É. (2017). La humanidad aumentada (J. Blanco y C. Paccazochi, Trad.). Buenos Aires, Argentina: Caja Negra.

Scott, J. C. (2020). Seeing like a state: How certain schemes to improve the human condition have failed. Veritas Paperbacks.

Žižek, S. (2015). Our Fear of Falling in Love. Canal de YouTube de Ghost.

Acerca de la autora / Agustina Lassi

Licenciada en Comunicación Social por la Universidad Nacional de la Matanza. Maestranda en Periodismo – UBA. Docente-Investigadora en Comunicación en la Universidad Nacional Arturo Jauretche y en la Universidad Nacional de La Matanza.